BTC/HKD+1.87%

BTC/HKD+1.87% ETH/HKD+2.83%

ETH/HKD+2.83% LTC/HKD-1.2%

LTC/HKD-1.2% ADA/HKD+2.18%

ADA/HKD+2.18% SOL/HKD+1.44%

SOL/HKD+1.44% XRP/HKD+1.5%

XRP/HKD+1.5%編輯:LRS

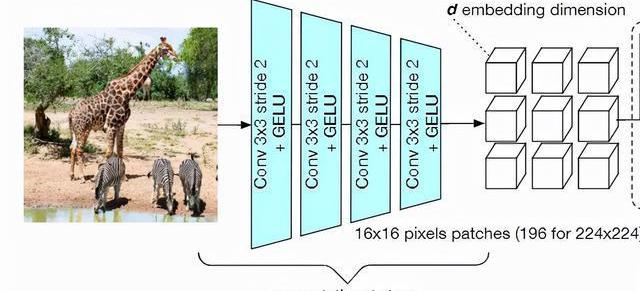

注意力機制這么好用,怎么不把它塞到卷積網絡里?最近MetaAI的研究人員提出了一個基于注意力的池化層,僅僅把平均池化層替換掉,就能獲得+0.3%的性能提升!

VisualTransformer作為計算機視覺領域的新興霸主,已經在各個研究任務中逐漸替換掉了卷積神經網絡CNN。

ViT與CNN之間存在著許多不同點,例如ViT的輸入是imagepatch,而非像素;分類任務中,ViT是通過對類標記進行決策等等。

classtoken實際上是ViT論文原作者提出,用于整合模型輸入信息的token。classtoken與每個patch進行信息交互后,模型就能了解到具體的分類信息。

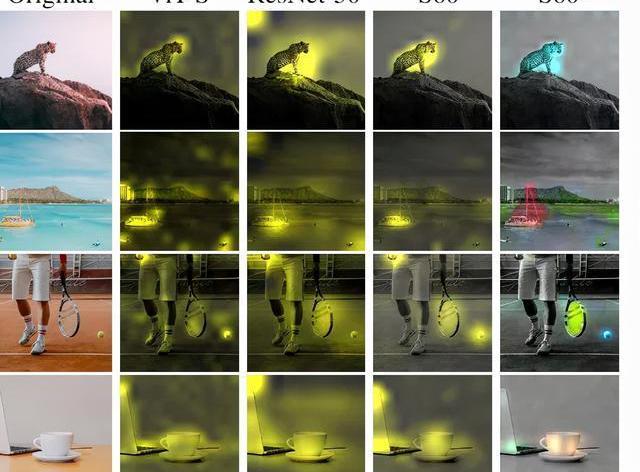

并且在自注意力機制中,最后一層中的softmax可以作為注意力圖,根據classtoken和不同patch之間的交互程度,就能夠了解哪些patch對最終分類結果有影響及具體程度,也增加了模型可解釋性。

但這種可解釋性目前仍然是很弱的,因為patch和最后一層的softmax之間還隔著很多層和很多個header,信息之間的不斷融合后,很難搞清楚最后一層softmax是否真的可以解釋分類。

CZ:CeFi如果能透明的話會比傳統金融更透明:金色財經報道,在今日舉行的Web3香港嘉年華峰會上,Binance創始人CZ表示,CeFi的交易所也可以是非常透明的,有很好的儲備證明并在區塊鏈上驗證。Binance 就有做這樣的事情,FTX 想做這樣的事情但沒有公開,CeFi如果能透明的話,其實比傳統金融更透明。[2023/4/12 13:59:22]

所以如果ViT和CNN一樣有視覺屬性就好了!

最近MetaAI就提出了一個新模型,用attentionmap來增強卷積神經網絡,說簡單點,其實就是用了一個基于注意力的層來取代常用的平均池化層。

仔細一想,池化層和attention好像確實很配啊,都是對輸入信息的加權平均進行整合。加入了注意力機制以后的池化層,可以明確地顯示出不同patch所占的權重。

并且與經典ViT相比,每個patch都會獲得一個單一的權重,無需考慮多層和多頭的影響,這樣就可以用一個簡單的方法達到對注意力可視化的目的了。

Coinbase經理承認在ICO上進行內幕交易:金色財經報道,Coinbase前產品經理IshanWahi在內幕交易案中認罪。2022年7月份,美國司法部表示,前Coinbase產品經理ISHANWAHI因向其兄弟NikhilWahi和一位朋友泄漏Coinbase上幣信息遭到指控。2022年9月,NikhilWahi在美國地方法院的虛擬法庭聽證會上對內幕交易的指控認罪,承認他根據Coinbase的機密信息進行交易,之后被判10個月有期徒刑。[2023/2/8 11:53:14]

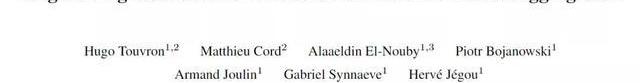

在分類任務中更神奇,如果對每個類別使用不同顏色進行單獨標記的話,就會發現分類任務也能識別出圖片中的不同物體。

基于Attention的池化層

比特幣全網未確認交易數量為8602筆:金色財經報道,BTC.com數據顯示,目前比特幣全網未確認交易數量為8602筆,全網算力為256.41 EH/s,24小時交易速率為2.71交易/s,目前全網難度為36.84 T,預測下次難度下調2.05%至36.08 T,距離調整還剩7天17小時。[2022/10/31 11:58:46]

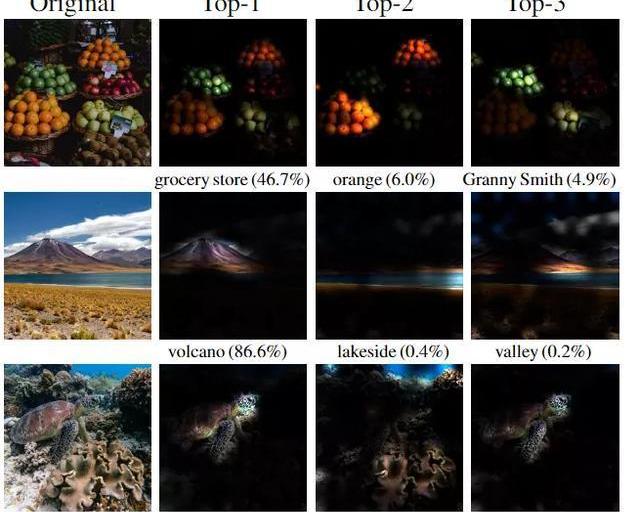

文章中新提出的模型叫做PatchConvNet,核心組件就是可學習的、基于attention的池化層。

模型架構的主干是一個卷積網絡,相當于是一個輕量級的預處理操作,它的作用就是把圖像像素進行分割,并映射為一組向量,和ViT中patchextraction操作對應。

最近也有研究表明,采用卷積的預處理能讓模型的性能更加穩定。

Tagus Capital:比特幣是對央行不負責任的印鈔行為的一種對沖:9月25日消息,最近流行于幣圈的說法是“一枚比特幣就是1枚比特幣”。這種觀點想表達的是,比特幣的價格是多少并不重要,因為供給是固定的,從理論上講,將會在長期內起到支撐價格的作用。Genesis Trading前衍生品主管Joshua Lim表示:“隨著比特幣價格大幅下跌,1 BTC= 1 BTC是比特幣最大化主義者半開玩笑的說法。他們認為,比特幣最終將成為一種記賬單位,所以不必在意價格,只要關注我們現在擁有的比特幣絕對數量就可以了。”

Tagus Capital的Ilan Solot表示,“比特幣不是通脹追蹤工具,它并不是通貨膨脹保值債券,價格也不會隨著通脹上漲而上漲,比特幣是對央行不負責任的印鈔行為的一種對沖。”(金十)[2022/9/26 7:20:19]

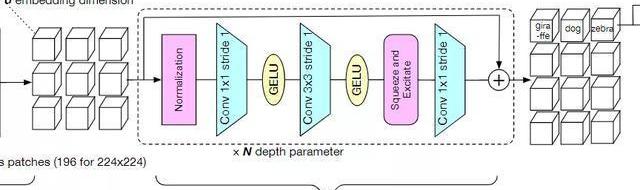

模型的第二部分column,包含了整個模型中的大部分層、參數和計算量,它由N個堆疊的殘差卷積塊組成。每個塊由一個歸一化、1*1卷積,3*3卷積用來做空間處理,一個squeeze-and-excitation層用于混合通道特征,最后在殘差連接前加入一個1*1的卷積。

高盛下調Coinbase股票評級,COIN股價盤前下跌5%:6月27日消息,高盛周一將美國加密交易所Coinbase的股票評級從“買入”下調為“賣出”,將其目標價從70美元下調至45美元。周一盤前交易中,COIN股價下跌5%。(The Block)[2022/6/27 1:34:33]

研究人員對模型塊的選擇也提出了一些建議,例如在batchsize夠大的情況下,BatchNorm往往效果比LayerNorm更好。但訓練大模型或者高分辨率的圖像輸入時,由于batchsize更小,所以BatchNorm在這種情況下就不太實用了。

下一個模塊就是基于注意力的池化層了。

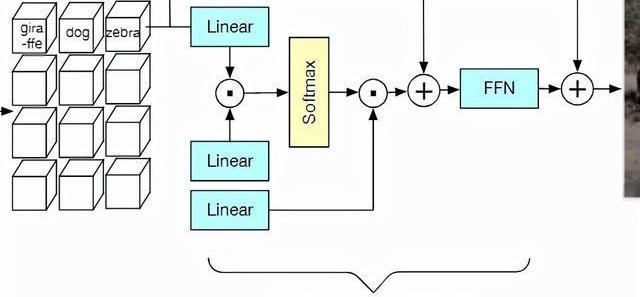

在主干模型的輸出端,預處理后的向量通過類似Transformer的交叉注意力層的方式進行融合。

注意力層中的每個權重值取決于預測patch與可訓練向量之間的相似度,結果和經典ViT中的classtoken類似。

然后將產生的d維向量添加到CLS向量中,并經過一個前饋網絡處理。

與之前提出的class-attentiondecoder不同之處在于,研究人員僅僅只用一個block和一個head,大幅度簡化了計算量,也能夠避免多個block和head之間互相影響,從而導致注意力權重失真。

因此,classtoken和預處理patch之間的通信只發生在一個softmax中,直接反映了池化操作者如何對每個patch進行加權。

也可以通過將CLS向量替換為k×d矩陣來對每個類別的attentionmap進行歸一化處理,這樣就可以看出每個塊和每個類別之間的關聯程度。

但這種設計也會增加內存的峰值使用量,并且會使網絡的優化更加復雜。通常只在微調優化的階段以一個小的學習率和小batchsize來規避這類問題。

實驗結果

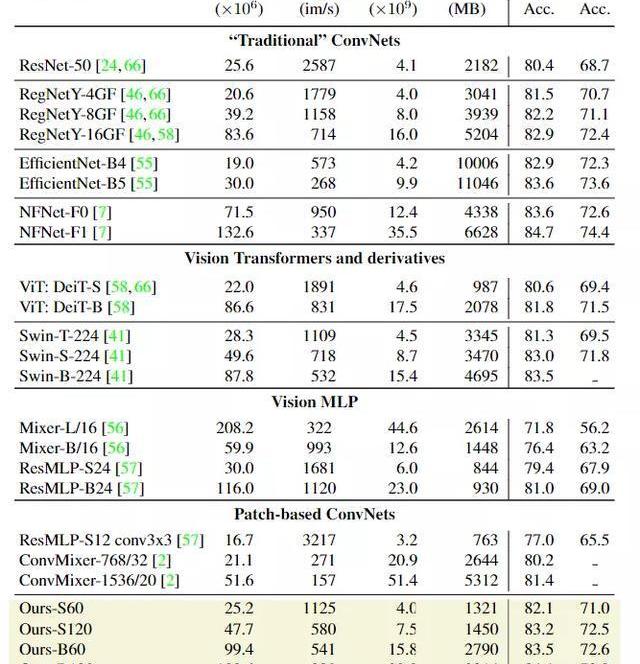

在圖像分類任務上,研究人員首先將模型與ImageNet1k和ImageNet-v2上的其他模型從參數量,FLOPS,峰值內存用量和256張圖像batchsize下的模型推理吞吐量上進行對比。

實驗結果肯定是好的,可以看到PatchConvNet的簡單柱狀結構相比其他模型更加簡便和易于擴展。對于高分辨率圖像來說,不同模型可能會針對FLOPs和準確率進行不同的平衡,更大的模型肯定會取得更高的準確率,相應的吞吐量就會低一些。

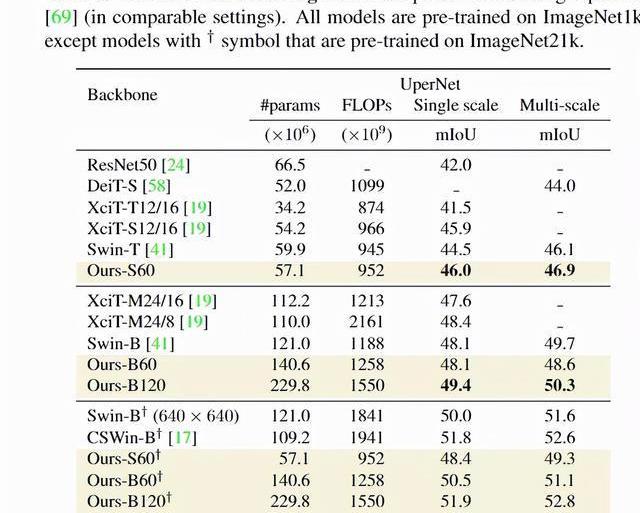

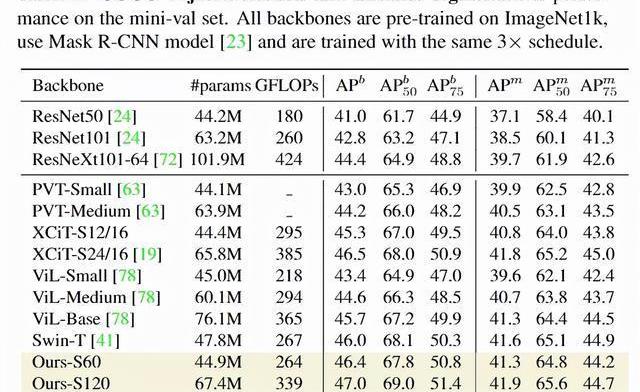

在語義分割任務上,研究人員通過ADE20k數據集上的語義分割實驗來評估模型,數據集中包括2萬張訓練圖像和5千張驗證圖像,標簽超過150個類別。由于PatchConvNet模型不是金字塔式的,所以模型只是用模型的最后一層輸出和UpperNet的多層次網絡輸出,能夠簡化模型參數。研究結果顯示,雖然PatchConvNet的結構更簡單,但與最先進的Swin架構性能仍處于同一水平,并且在FLOPs-MIoU權衡方面優于XCiT。

在檢測和實例分割上,研究人員在COCO數據集上對模型進行評估,實驗結果顯示PatchConvNet相比其他sota架構來說,能夠在FLOPs和AP之間進行很好的權衡。

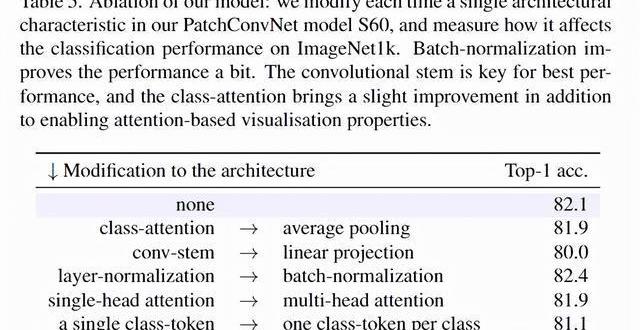

在消融實驗中,為了驗證架構問題,研究人員使用不同的架構對比了Transformer中的classattention和卷積神經網絡的平均池化操作,還對比了卷積主干和線性投影之間的性能差別等等。實驗結果可以看到卷積主干是模型取得最佳性能的關鍵,class-attention幾乎沒有帶來額外的性能提升。

另一個重要的消融實驗時attention-basedpooling和ConvNets之間的對比,研究人員驚奇地發現可學習的聚合函數甚至可以提高一個ResNet魔改后模型的性能。

通過把attention添加到ResNet50中,直接在Imagenet1k上獲得了80.1%的最高準確率,比使用平均池化層的baseline模型提高了+0.3%的性能,并且attention-based只稍微增加了模型的FLOPs數量,從4.1B提升到4.6B。

參考資料:

https://arxiv.org/abs/2112.13692

新京報訊2月21日,科興制藥發布公告宣布,全資子公司深圳科興藥業有限公司與深圳安泰維生物醫藥有限公司簽署《SHEN26項目合作協議》.

1900/1/1 0:00:00TIPS 1、下載IT桔子APP,實時跟蹤國內外一級市場投融資事件。2、轉載請注明來源自IT桔子,侵權必究。3、建立“投資速遞”長期發布合作,請發郵件到hello@itjuzi.com.

1900/1/1 0:00:00數字人民幣App上線的消息持續發酵,正在A股掀起一股“金融科技”熱。1月7日,數字貨幣概念股繼續走強,神州信息、楚天龍、御銀股份悉數漲停,旗天科技、京北方、創識科技、新國邦等均漲逾6%.

1900/1/1 0:00:00大公司: 反壟斷審查一年多,Meta完成10億美元收購Kustomer在經過一年多的反壟斷審查后,Facebook母公司Meta終于獲準完成對客戶服務軟件公司Kustomer的收購.

1900/1/1 0:00:00十分鐘深度了解引爆科技圈的元宇宙——核心觀點總結如果一個項目想要成功必須同時滿足多方的訴求,那么元宇宙正好滿足了成為成功項目的條件.

1900/1/1 0:00:00臨近年末,多家加密貨幣平臺陸續自行關停對中國大陸用戶的服務,15日是交易所火幣全球站幣幣交易對大陸用戶開放的最后期限。用戶紛紛通過各類途徑轉出資產,或尋求提供同類服務的平臺.

1900/1/1 0:00:00